Cómo ordenar el sueño de los adolescentes y niños ante la vuelta a clases

Llegó la vuelta a clases y para muchos la ansiada vuelta a la rutina. Eso trae un desafío inevitable: cómo volver a despertarse más temprano.

Big Data es un término que hace referencia a conjuntos de datos tan grandes y complejos que precisan de aplicaciones informáticas no tradicionales de procesamiento de datos para tratarlos adecuadamente.

Tendencias - Opinión17/04/2022 EZEQUIEL ELIANO SOMBORY (*)

En los últimos años, el meteórico advenimiento tecnológico conllevó a que las organizaciones y todos nosotros generemos una gran cantidad de información capaz de ser utilizada a priori para distintas aplicaciones. Ese fenómeno se volvió masivo y se formalizó de una manera tan repentina que empezó a hablarse de él sin tener tanto conocimiento real sobre su origen, sus usos y sus alcances. Por eso es crucial desmitificar algunas cuestiones para que sepamos de qué hablamos cuando hacemos referencia al Big Data.

1) A cualquier volumen de información se lo puede denominar big data

Esto no es así. En realidad, el concepto de Big Data se refiere a los datos que son tan grandes, rápidos o complejos que es difícil o imposible procesarlos con los métodos tradicionales. Si bien hace mucho tiempo que se accede y almacena información, este concepto surgió en los 2000 cuando el analista de la industria, Doug Laney, articuló la definición actual de grandes datos como las tres V (velocidad, veracidad y variedad).

Aunque no existe un consenso acerca de qué volumen estrictamente implica "big data", pero se suele aceptar que a partir de un terabyte puede ser considerado como tal.

2) Cualquier procesamiento o análisis de datos requiere de un algoritmo

El desarrollo de un algoritmo es muchísimo más complejo e implica previamente toda una gestión del dato (como antes mencionamos) para llegar a una capa explotable.

Luego dichos datos deben pasar por un estricto entrenamiento, validación y puesta productiva del algoritmo. Dicho de otro modo: el algoritmo debe pasar por un riguroso proceso de validación científica antes de llegar a ser parte de la Inteligencia Artificial que consumimos y usamos todos los días

3) Si memorizo algunos códigos en Python puedo hacer Machine Learning (ML)

Esto tampoco es real. Si bien Python es hoy en día uno de los principales lenguajes sobre los que se puede hacer Machine Learning, no es el único y seguramente aparezcan superadores. Más allá de la tecnología, lo importante al querer aplicar esta disciplina (ML) es comprender y entender su lógica, como también la estadística que hay detrás y sus potenciales casos de uso.

4) La inteligencia artificial llegó para quedarse

Es muy probable que esto sea verdadero, ya que la Inteligencia Artificial forma parte de nuestra cotidianidad y se han generado muchos ecosistemas e industrias bajo esta tecnología; desde una empresa que testea un remedio, hasta la industria de la publicidad y las búsquedas programáticas en Google.

La inteligencia artificial ya muestra un profundo impacto en las empresas que la han adoptado. ¿Por qué? Básicamente, porque optimizan los costos y maximizan la ganancia ayudando a que las empresas ofrezcan más y mejores servicios particularizados a cada cliente (el famoso excedente del consumidor).

5) Sólo las grandes empresas de datos necesitan expertos en el área

Otro mito a derribar: las áreas de BI, Data Scentist y IT cada vez están más insertas en las pequeñas empresas, firmas digitales (e-commerce), startups, empresas energéticas, de telecomunicaciones, de pagos, ONG, Gobiernos, y muchos otros tipos de organizaciones.

Cada día, a menor costo, las empresas generan, gestionan y analizan más datos que son el insumo para tomar decisiones bajo la cultura "data driven". Los datos y los perfiles que trabajan sobre ellos permiten llegar a conclusiones y tomar acciones que sólo mediante la intuición y el conocimiento de negocio no podrían llegar.

(*) Director de la carrera de Analítica Social y Empresarial del Instituto Tecnológico de Buenos Aires( ITBA), Lic. en Economía y Magíster en Política y Gestión de la Ciencia y la Tecnología (UBA).

Llegó la vuelta a clases y para muchos la ansiada vuelta a la rutina. Eso trae un desafío inevitable: cómo volver a despertarse más temprano.

Faltan pocos días para el comienzo de las clases, momento especial para revisar el calendario de vacunación y prevenir enfermedades. Al respecto opinó el médico pediatra Norberto Giglio, experto en epidemiología del Hospital de Niños Ricardo Gutierrez.

La falta de motivación laboral es un síntoma que puede afectar a cualquier persona, sin importar edad, profesión o cargo y los motivos son diversos.

Para competir con las tiendas chinas, marcas como Zara y Macowens lanzaron descuentos de hasta 70%. Además, ofrecen la opción de pagar en 6 cuotas sin interés.

Es una de las herramientas que está utilizando el Tesoro para comprar divisas sin impactar sobre el mercado cambiario.

Así, se registraron 3488 nuevos casos de tuberculosis en Argentina, una cifra que excede la mediana de los cinco años previos, que era de 2530 casos.

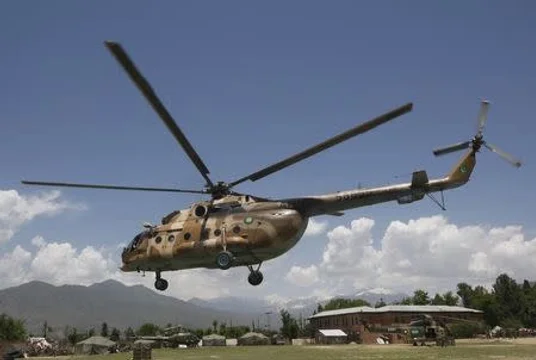

Un nuevo ataque suicida en Pakistán.

El triunfo quedó en manos del piloto británico Lando Norris.